研究 / Research

コンテンツ科学研究系

研究紹介

AI画像認識技術の最先端をひらく

大量の画像を瞬時に認識する技術

人間の「見てわかる」能力を、コンピュータに与えてみたい。そう思って私は、大学院の頃からずっと、コンピュータに画像を理解させるための研究を続けてきました。原点には、小学生のときに芽生えた「なぜ人間は見たものを理解し、声や音を聞き分けることができるのか?」という疑問があります。ですから、プログラミングをすることで、人間の認知の仕組みを研究してきたともいえます。

画像認識の世界は、2012年のディープラーニングによる技術革新(*1)を機に大きく進展しました。コンピュータはいま、画像に写るものを物体単位で認識し、その輪郭をきれいに切り取ることもできます。世界の研究の主流はその認識精度をさらに高めることに向いていますが、その精度を生かすためには大量のデータから、素早くかつ正確に画像を見分けるための技術が必要で、私はこれを手がけました。

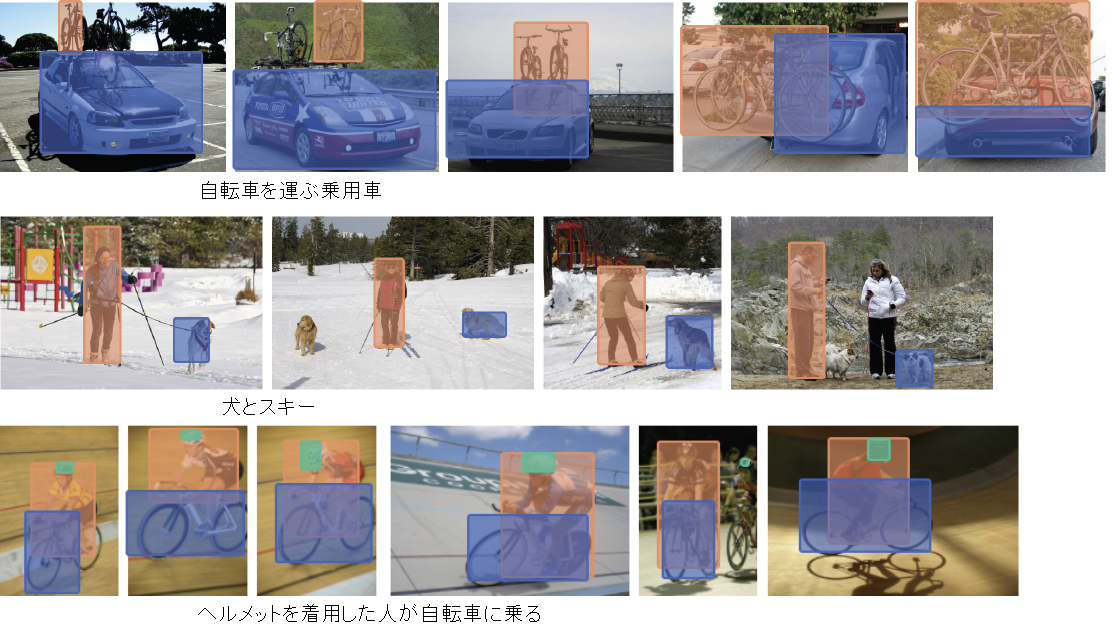

例えば、一枚一枚の画像が表わすものの要素を、事前にAIに解析させてインデックス化することで、求める画像とは関係のないすべてのデータを瞬時に捨てさせるアルゴリズムを開発しました。この技術によって2016年、通常のPCで、100万枚の画像の中から求める画像を0.5秒で抽出することに成功しました。また、物体間の位置関係を柔軟に扱える画像検索システム、物体間の関係までを含む複雑な検索意図を自然言語の説明文による問合せとして扱える技術(写真)、画像データベース中の類似画像の分布度合いに基づく高精度かつ高速の画像検索技術等を実現しました。

〈写真〉検索者の意図を柔軟にくみ取れる画像検索システム

動く画像の意味を解析する

最近では、動画を使って、コンピュータに「画像の意味」を理解させる研究もしています。動画解析には、世界の研究者たちも熱い視線を向けていますが、未だ静止画ほどには及んでいません。ものの動作や動きにはバリエーション数が多いため、AIに学習させるためには、静止画に比べて大量の画像データが必要となるからです。

そこで私たちの研究チームは学習量を低減させるための方法として、「動画を見る目」に着目しました。人間の目は動くものを見るとそれ以外のものに意識が向かなくなります。同様に、コンピュータにも動く物体の塊のみを追跡させれば、AIの学習量を減らすことができるはずです。

一方で、私たちは、AIに学習させる動画データの蓄積も進めています。テレビ放送全7局の全ての番組を10年間、数秒単位で録画した映像をアーカイブしており、日常生活に関する知識をほぼカバーしています。視聴率との関係を解析したところ、天気予報やスポーツ、小動物の映像などで上がる傾向があるなど、人々の興味についての洞察も得られました。

AI画像診断のビッグプロジェクト

その他の取り組みとして、2017年にNIIが新たに開設した「医療ビッグデータ研究センター」のセンター長として、日本医療研究開発機構(AMED)や医学系7学会と連携しつつ、画像診断支援システムの開発も進めています。

AIによる画像診断技術は、病理の分野ではすでに十分なレベルを達成し、福島の地域ネットワークなどで実用化が始まっています。病理のほかに、内視鏡、放射線、皮膚科、眼科、超音波の全6疾病科を対象として実用化を目指していますが、科によって画像診断の役割や考え方が違うため、一律に対応することはできません。それぞれに最適な画像診断技術の確立を急いでいます。

また、このシステムを実際に運用する場合には、データを管理するための全国レベルのプラットフォームの構築が必要です。現在では、NIIが構築・運用する「SINET5」を使ったクラウド基盤の整備がほぼ終了し、多くの研究成果が続々と生み出されてきているところです。

(*1)この年、ジェフリー・ヒントンらのグループが、画像認識コンテスト「ILSVRC」http://image-net.org/challenges/LSVRC/において、ディープラーニングを使ったニューラルネットワークの数理モデル「Supervision」により画期的な的中力(誤り率15.3%)を記録し、この数理モデルは画像認識技術のブレイクスルーとなった。また同年、米Googleがウェブ上の画像を機械学習して猫の画像を自動認識し、注目された。

関連情報

ITによる新しい医療支援-医療ビッグデータクラウド基盤構築とAI画像解析研究:医療ビッグデータ研究センター

リンク

- 「どこまでできる画像検索?! 〜深層学習技術で目指す画像を見つけ出せ〜」 佐藤 真一 - 国立情報学研究所 2020年度 市民講座 第4回

- [NII SEEDS] COVID-19診断支援AIの開発に向けたICTプラットフォームの構築をめざす

- [NII Today] CT画像の解析結果を感染症対策に役立てる - NII Interview (89-1)

- [NII SEEDS] 高速・高精度な画像検索と放送映像アーカイブ解析

- [NII SEEDS] 実放送映像による実践的アプローチと大規模映像アーカイブからの知識発見

- 画像・映像を楽しく検索してみよう-画像・映像の直感的検索システムとマイニング:佐藤真一、松井勇佑、日並遼太

- [書籍] 石頭なコンピュータの眼を鍛える コーパスで人間の視覚にどこまで迫れるか - 情報研シリーズ12

国立情報学研究所

国立情報学研究所 国立情報学研究所 2025年度 概要

国立情報学研究所 2025年度 概要 NII Today No.104

NII Today No.104 SINETStream 事例紹介:トレーラー型動物施設 [徳島大学 バイオイノベーション研究所]

SINETStream 事例紹介:トレーラー型動物施設 [徳島大学 バイオイノベーション研究所] ウェブサイト「軽井沢土曜懇話会アーカイブス」を公開

ウェブサイト「軽井沢土曜懇話会アーカイブス」を公開 情報研シリーズ これからの「ソフトウェアづくり」との向き合い方

情報研シリーズ これからの「ソフトウェアづくり」との向き合い方 学術研究プラットフォーム紹介動画

学術研究プラットフォーム紹介動画 教育機関DXシンポ

教育機関DXシンポ 高等教育機関におけるセキュリティポリシー

高等教育機関におけるセキュリティポリシー 情報・システム研究機構におけるLGBTQを尊重する基本理念

情報・システム研究機構におけるLGBTQを尊重する基本理念 オープンサイエンスのためのデータ管理基盤ハンドブック

オープンサイエンスのためのデータ管理基盤ハンドブック 教育機関DXシンポ

教育機関DXシンポ コンピュータサイエンスパーク

コンピュータサイエンスパーク