Article

AIが判決の理由を推論する(PROLEG)

判決推論システム PROLEGの可能性

佐藤健教授らが開発した判決推論システム「プロレグ(PROLEG)」では、人工知能(AI)が判決に至った理由を推論することができる。 プログラミング言語の一つである「論理プログラミング」が組み込んであるため、AIがブラックボックス化せず、「説明可能なAI」となるわけだ。 司法分野へのAIの導入を社会が受容できるかどうか考えるうえで、その意義は大きい。

佐藤 健SATOH, Ken

国立情報学研究所

情報学プリンシプル研究系 教授

例えば刑事裁判の場合、まず検察側と弁護側がそれぞれ証拠を並べ、どういう事実があったかを確認していく(事実認定フェーズ)。次に、そうした事実の違法性について判断するのに、どんな法律のどの条項が関係してくるのかを議論する(当てはめフェーズ)。ここまでで材料は出そろったので、最終段階として、裁判官が有罪か無罪か決定を下す(判決フェーズ)。

テレビの法廷ドラマなどでは、入り組んだ謎が解明されるにつれ、被告人が逆転無罪になることもある。普通の民事裁判でも、そもそも原告と被告の言い分が大きく食い違ってもめて裁判沙汰になるわけで、一口に「事実」といってもそれは明白でなく、微妙な判断が求められる。この第一段階の事実認定およびそれに続く第二段階のあてはめは、依然として検察官なり弁護士なりの人間がカバーする領域となる。

PROLEGの論理

佐藤教授らが開発したPROLEGは原則として、コンピュータが扱いやすい最終段階の「判決フェーズ」をカバーする。将来、証拠を基にある程度の事実認定およびあてはめをこなせるようになれば、PROLEGを「AI裁判官」や「AI陪審員」と呼ぶこともできようが、現状では、「法律専門家の判断支援ツール」や「判決エキスパートシステム」と言う方が適切だろう。

裁判では、白黒の決着がつかない論点が残り、曖昧なグレーゾーンがある中でも、人間は「これまで出された材料から総合的に考えれば、こういう結論が妥当だ」と判断する。コンピュータも原則や例外規定を網羅したルールに則って、不完全な情報の中でも、全体として矛盾が生じない結論を探し出すことができる。

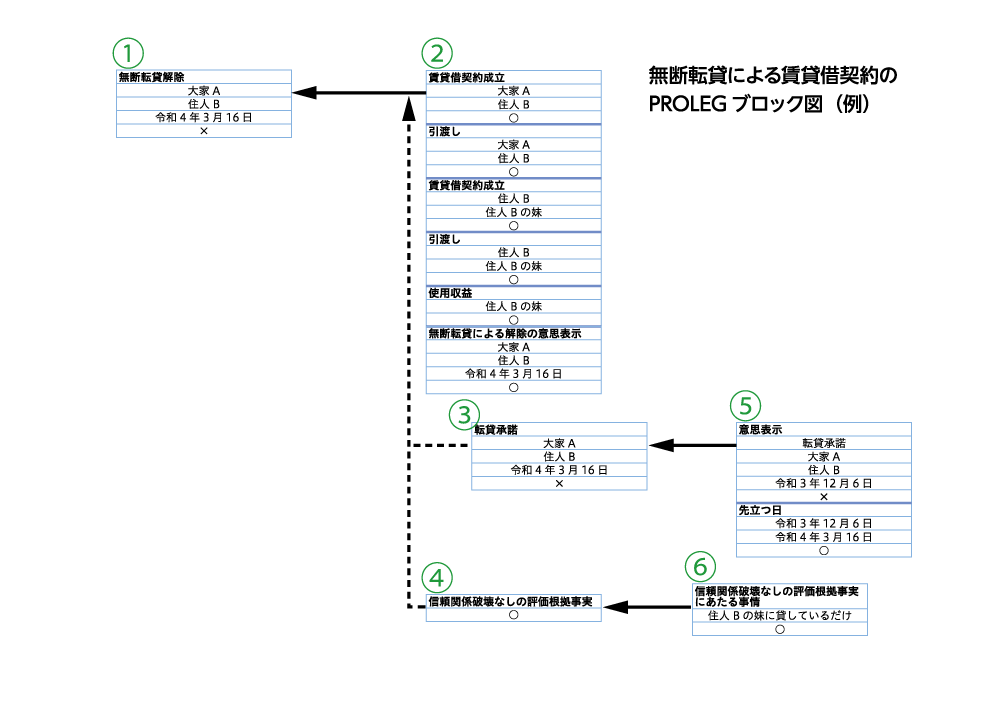

具体的な手順としては、例えばアパートの賃借人(住人B)が、賃貸人の大家(大家A)に相談せず、部屋を妹に又貸しした場合を考えてみる(図参照)。「勝手なことをされては困る」と怒った大家は、賃貸借契約の解除を言い渡すが、賃借人は「このぐらいのことで解除なんておかしい」と立ち退きを拒否したため、大家が裁判に訴える。

そもそも賃貸借契約が確かに存在していたとか、妹に又貸ししていたということが事実だと確認されたという前提のもとに、PROLEGの論理の組み立てを追うと、次のようになるだろう。

法的には、契約が成立していたら解除はできないが、これには例外があり、何らかの契約違反があれば大家は解除できる→又貸しは契約違反に相当する→ゆえに大家は解除できる。しかし、この解除規定についてもやはり例外があり(例外の例外)、大家が事前に又貸しを承諾していた場合には解除できない→今回、大家は承諾していないので解除できる。さらにもう一つの例外規定もあって、賃借人と大家の信頼関係が破壊された場合には解除できる→今回のケースでは、妹に又貸ししたことが大家との信頼関係を損ねる行為かどうか......というふうにPROLEGがすべての原則、例外、例外の例外について、漏れがないようチェックしたうえで結論を下す。

賃貸借契約訴訟の経験が豊富な弁護士からすると、「それは私が日々、行っている仕事です。プロとしての長年の経験や知識から、むろん勘所は心得ており、わざわざコンピュータに教えを請うには及びません」という感想を持つかもしれない。しかし、このシステムは、新人弁護士が論点の見落としや議論の組み立ての誤りがないかチェックしたり、素人が裁判の相場観を探ったりすることにも使える。ベテランのノウハウを、新人や素人にも提供できるのがPROLEGのメリットだ。何でも処理できる汎用システムに対して、このように特定の分野に通じたものは「エキスパートシステム」と呼ばれる。佐藤教授が「過度な期待をせずに限界を知り、適切な分野に適用するということを守れば、エキスパートシステムは十分に効果を発揮する。逆に、汎用性を狙うと失敗することが多い」と指摘するとおり、派手さはないが手堅い手法と言える。

現実に役立ちそうなPROLEGながら、法曹による利用はあまり進んでおらず、研究・試験段階にとどまっている。一番のボトルネックは、事実関係の入力などを、日本語や英語といった自然言語ではなく、コンピュータのコードで入力しなければならない点だ。プログラムに不慣れな法曹にとってハードルが高く、「ちょっと使ってみよう」という気にはならないのも当然かもしれない。この点は今後の改善が待たれる。

当面は、コンピュータコードではなくプルダウン式で項目を選択していく方法も検討中とはいえ、この方式にしても、プルダウンメニューにするQ&Aの流れをどう作っていくかが難しいという。

佐藤教授は「ユーザは、AIといえば日本語で書けば自動的に判決が出てくる自動販売機のようなものを求めるので、ユーザに負担がかかるシステムはなかなか使ってもらえない」と話す。

PROLEGが参照するルールの実体は、民法及び最高裁判例から得られた規範からなる2,500ぐらいのルールだ。これほどの大規模なシステムは世界にも例をみないという。東大の法科大学院の修了生をアルバイトとして雇い、司法試験の短答式の問題のうちPROLEGで解けそうな問題を解かせ、きちんと作動することが確認されている。

ただ、裁判所の判決文は、必ずしも論理の流れや理由を詳細に記述しているわけではないため、こうしたルールの入力にも限界がある。判決文の文章では、どうしてもはっきりと分からないブラックボックスの部分が残る。最高裁判例の場合、専門的な解説などが利用できるものの、そうした権威ある詳細分析が蓄積されていない下級審を含め、判決を広くコンピュータにルールとして採り入れる方策については「お手上げの状態」(佐藤教授)という。

PROLEGのようなシステムの延長線上には、さらにAIの可能性が広がっている。法曹が多くの判例を見て、次第に自分の頭の中に判定基準を形成していくといったいわば職人芸を模倣するには、理論上、過去の大量の判例を読み込んで機械学習することが考えられる。また、正当防衛と判断された判決を大量に入力して、正当防衛の認否の的中率が最大になるように脳の神経回路網を模して作った計算モデルで重み付けを学習させれば、新しい事件があったときに判決を予想できるはずだ。しかし、こうした大量の学習データが必要な手法については、現在、判決が電子データとして公開されていないため研究が進んでいない。

↑図は、無断転貸解除についてのPROLEGによる法的推論を表している。①の一番下の要素が「×」になっており、無断転貸解除が不成立であることを表し、その結論が得られるまでの推論が右側に示されている。また、「無断転貸解除」の原則の要件である②が実線の矢印で結論につながれており、すべて成立(〇で表示)している。しかし本件では考慮すべき例外が2つ(③、④)あり、③の転貸承諾は不成立だが、④の「信頼関係破壊なし」の抗弁が成立している。したがって、たとえ原則が成立していても、例外が成立しているため、結論の「無断転貸解除」が否定されている。②、⑤、⑥のブロックは事件上の法的事実を表しており、事実認定フェーズおよび当てはめフェーズを経て決定される。(解説:佐藤健)

人間よりAIの審査がいい!?

ただ、深層学習を使った場合、結果については「計算したところ、こういう出力になった」としか言えず、途中の膨大な計算過程は複雑過ぎて、決定過程はブラックボックスになってしまう。「深層学習の結論自体は正しい」と言われて納得しても、では「深層学習が死刑と結論したので死刑です」と言われて、果たして人間は納得できるだろうか。その点、PROLEGではロジックの流れが追跡できるので、どこが分岐点となり判決が導かれたか、理由を確認でき、人間が判決を理解できる人間に優しいシステムとなる。

司法分野にAIを導入することについては懐疑的な見方も根強いだろう。しかし、歴史的には、職業裁判官ではなく一般の市民でも正しい判決を導けるという合意ができて、裁判員制度が始まった。将来、市民だけでなくAIでも妥当な判決を導けるという合意ができる可能性はあるだろう。

司法制度の信頼という観点では、イスラエルの研究者による興味深い論文(「Extraneousfactors in judicial decisions」)を思い出す。8人の裁判官が計千人以上の囚人に対して保釈を 認めるかどうか審査した様子を 詳しく分析したもので、裁判官らは朝、登庁すると最初は気前よく保釈を認めているが、昼前にかけて保釈を渋るようになる。ランチの直後、再び保釈率は上昇し、夕方にかけてまた保釈率は低下に向かうというような内容だった。

つまり、心理的な疲労が蓄積すると、何も考えずに「保釈しない」というデフォルト値に判断が戻っていくわけだが、もっと強い言い方をすれば、保釈されるかどうかは、囚人の服役態度や更生の可能性などよりも、裁判官の血糖値に影響されるということだ。余裕があると、じっくり考えて寛大になり(保釈を認める)、空腹を感じイライラしてくると安易に厳しい結論に飛びつく(保釈しない)というのは、我々の日常の経験に照らしても納得できるところだ。こんなことなら、人間よりAIに審査してもらいたいと希望する囚人は多いのではないか。

裁判では、昔は「わいせつ」とされたものが、時代の変化とともに「わいせつとは言えない」と変わっていく。一審の判決が、二審でひっくりかえることもよくある。新しい証拠が提出されたわけでなくても、裁判官が異なれば、考え方や価値観も異なるので判決が変わるのは不思議でない。仮に将来、高度なAIが司法に導入されたとして、判決の揺れは収束していくのか、それとも人間の意見が一人一人違うように、何かちょっとした差異により判決にばらつきが出るのか。人工知能法学の未来には、哲学的な問題も横たわっているように感じる。

(取材・文 山田哲朗 読売新聞論説委員)