Article

賢いロボットをつくるために、仮想空間でロボットと対話する

クラウドとVR を活用するシミュレータの意義とは

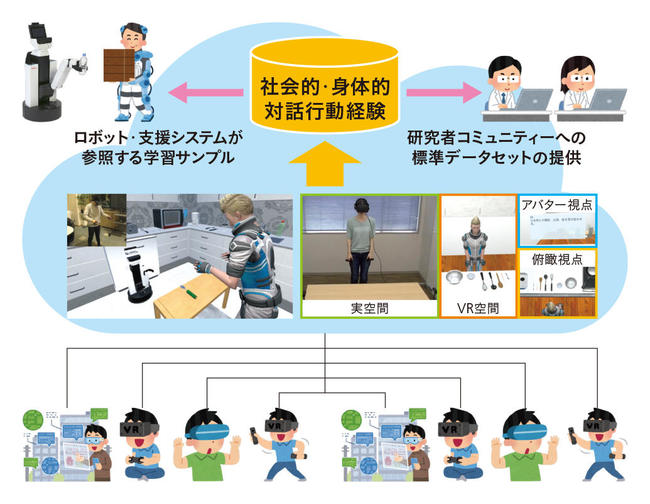

日常生活で人とインタラクションしながら社会的・身体的経験を通じて、学び成長するロボットを実現するためには、シミュレータの活用が有効だとNIIの稲邑哲也准教授は考えている。詳細かつ大量のマルチモーダルデータを低コストで集められるからだ。クラウドとVRを活用する社会的知能発生学シミュレータ「SIGVerse」による対話経験蓄積を通じて、ロボットを知能化する取り組みについて聞いた。

稲邑哲也Tetsunari Inamura

国立情報学研究所 情報学プリンシプル研究系 准教授/総合研究大学院大学 複合科学研究科 准教授

社会的知能発生学シミュレータで学習データを蓄積

機械学習は、いまやあらゆる分野で使われている。ロボットにおいても、物体をつかむスキルや運転するスキルなどを機械学習で向上させられることが明らかになっており、今後も加速していくと考えられる。

稲邑哲也准教授は学生時代から人間とロボットのインタラクション(やりとり)を研究してきた。会話や見真似を通じて人間と関わり合いながら育っていくロボットに興味があるという。

ロボットも機械学習の一種である深層学習で賢くなると考えられるが、残念ながらボトルネックがある。学習のための教師データが取得できないのだ。物体のピッキングや自動運転は多数のロボットを並列して朝から晩まで動かしたり、ひたすらドライブしたりすることでデータを取得することができる。だが人間相手のやりとりで似たような方法を実行するのは難しい。 例えば、介護の現場でどうやって人を抱きかかえればいいのか、店舗の現場でどのように接客すれば顧客満足度は上がるのか、それら全てに人間が付き合わなければならないからだ。

どうすればロボットが実験室内でやりとりを繰り返すようなスタイルではなく、ごく自然にインタラクションしながら学習データを蓄積することができるのか。稲邑准教授が取っている戦略がロボットシミュレータだ。

社会的知能発生学シミュレータ「SIGVerse」はクラウド型VRプラットフォームである(図 1)。クラウド上にVR空間をつくって、そこにシミュレータをおいてロボットを動かし、人もそのなかでバーチャルエージェントとして行動することで、人とロボットがインタラクションする。クラウドを使うことで、従来のように研究室にまで実際に来てもらって実験に参加してもらうのではなく、インターネット越しに世界中の人にログインしてもらうことで、同時に多人数の実験ができる。「従来スタイルでは到達できないスケールでの実験ができる」と稲邑准教授は語る。「SIGVerse」上にはすでに 1 万時間の行動履歴が蓄積できる準備が整っている。

多くの人の行動から共通項を見いだして見真似学習する

ロボットのプログラミングスタイルも変わりつつある。これまではプログラミングや、コントローラーを使った遠隔操作でロボットに動作を教える方法が一般的だった。それに対して近年の研究トレンドは「Learning by Demonstration」、つまり人間がやってみせて、それを何らかの方法でロボットに伝えることでロボットが学ぶ「模倣学習」だ。稲邑准教授らは、それをVRのなかで行っている。

例えば人間が台所での皿洗いを教える。まず複数の被験者がVRのなかで皿洗いの動作をやってみせる。その挙動は VR中のカメラで観察されており状態遷移図として表現される。どちらの手でスポンジを持ち、どのタイミングで水につけるのかといった「各人の皿洗い戦略」は異なるが、どういう順番で物体を接触させていくのかということが状態遷移図で表現される。どういうアクションからどういう状態に移るのかが明示されるのだ。そして、状態遷移図からは共通項を見いだすことができる。

「ほとんどの人が右手でスポンジを持っていて、左手でお皿を持っている状態を経験していれば、これは『頻度の高い状態なので、そこは踏襲しなければならない』と判断されます。一方、非常にまれな状態、例えばゴミ箱のなかにコップを捨てるような行動はノイズ(雑音)として切り捨てます。そうすることでロボットが取るべき行動を見いだします」

この研究はドイツ・ミュンヘン工科大学のゴードン・チェン教授たちとの共同研究だが、VR空間にログインするための環境とHMD機材さえあれば、誰でもどこからでも参加できる。

インタラクションは行動の見真似だけではない。ロボット側から人間に質問で確認したり、人間から指示を与えることでスキルをどんどん向上させたりする対話システムを構築することもできる。

ただし現状のロボットは因果関係を理解しているわけではないし、作業自体の最終目的もわかっていない。例えば皿洗いの目的が皿を綺麗にすることだと理解しているのではなく、単に動作を模倣しているにすぎない。その課題の根本的解決策はいまだに見いだせていない。

「バットの素振りなら関節角度を真似ればいいだけです。しかしバットをボールに当ててホームランを打つとなると、模倣すべき対象が何なのかをロボットが自分自身の力だけで突き止めることは難しいのが現状です」

人間が日常生活で行うこともさまざまなレベルがある。稲邑准教授は完全にロボットが自律的に判断するのは当面は難しいと考えて、人間が指示などで教師信号を適宜入れていく、そして指示を自然に模倣学習に取り込めるようなシステムが必要だと語る。

人をナビゲーションするシステム

稲邑准教授らは、ロボットの競技会「ロボカップ」において「ヒューマンナビゲーション」という競技を創設して、人とインタラクションできるシステムづくりにも取り組んでいる。通常のロボコンと違い、VRプラットフォームを使うことでより 公正・低コストでハードウエアトラブルのない競技を実現するのが狙いだ。実ロボットを使った競技でのタスクは家庭内で人間に指示された何かをロボットが取って来るというものだが、 ヒューマンナビゲーション競技では、ロボットがVR空間にログインした人間に対して指示を出す。

ロボットには、三次元のXYZ座標位置で指定された物体を別の座標位置に移動させよという問題が送信される。競技に参加した各チームは、その三次元座標を人間に理解できるように、例えば「目の前のテーブルの上のマグカップをキッチンのシンクに入れてください」といった自然言語に変換するプログラムを書く。人間は自分自身の向きを次々と変えてしまうので、上下左右のような人中心の座標での指示語を使うには人間の状態も把握しなければならない。システムからのナビゲーションに応じて人間が迷わず行動できれば高得点が得られる。

次回の本番は2020年10月に愛知県で開かれる「ロボカップ・アジアパシフィック大会」で行われる。参加目標チーム数は8。日本からは4チームが参加する予定だ。

家庭用ロボットは最後の砦

稲邑准教授が取り組んでいるもう一つの柱が、ロボットが人間に対してお願いする能力だ。ロボットが何でも自分でやろうとするのではなく「できない」と思ったら人間に頼めばいい。

「家庭はロボットにとって最後の超難関です。ロボット準拠住宅のようなものを新たにつくるのであれば別ですが、一般家庭でお皿を洗ったり洗濯物を畳んだり、自力で何でもできるロボットを実現するのは相当難しい。そこで『掃除ができないので物をどかしてください』とロボットが頼むことで、できることを増やして、より快適な生活にしていくのが一つのあるべき姿だと考えています」

「できないこと」を頼むためには、ロボットは自分自身が「できること」、つまり物理的な限界を認識する必要がある。そのためにもシミュレーションが重要なファクターになる。人間が脳内で想像するように、何ができて何ができないかを具体的に把握する必要があるからだ。

ロボットが世界の精緻なモデルを自らつくり、リアルタイムに更新していく機能も必要だ。稲邑准教授は、いまはまだ「2歩先」の研究だと考えているそうだが、最後の砦である家庭にも挑んでもらいたい。ナビゲーションや行動の共通項を見いだす機能は生産現場やサービス業の最適化にも活用できそうだ。

(取材・文=森山和道 写真=佐藤祐介)