Article

人間の目では見えないものを機械の目であぶり出す

特殊で高価なカメラの性能を汎用シリコンカメラで実現するソフトウエアの開発

近年、画像認識技術が急速な進化を遂げ、またAI の世界における機械学習や深層学習(ディープラーニング)という言葉が一般にも広く浸透してきたことを受け、コンピュータビジョン(機械の目)での情報センシング技術に対する関心が産業界からも高まっている。そして人々にとってもっとも汎用的な“機械の目” であるシリコンカメラの精度をソフトウエアによってさらに高めようと研究しているのがNII の鄭 銀強准教授だ。現在の“機械の目”では何が見えるのか、そして今後どう発展していくのか。鄭准教授に聞いた。

鄭 銀強Zheng Yinqiang

国立情報学研究所 コンテンツ科学研究系 准教授/総合研究大学院大学 複合科学研究科 准教授

一般的なカメラで暗闇での鮮明な動画撮影を可能に

─最近はどんな研究をされているのでしょうか。

鄭 可視光しか捉えられない人間の視力は「情報をセンシングする」という点からいえば不十分なものです。とくに暗闇や水中といった場所で人間の目に見えるものはほんのわずかしかありません。しかし"機械の目"、例えば、電子増倍機能が搭載されているEMCCD カメラなどを使えば、暗闇の中でもさまざまな情報を画像として浮かび上がらせることが可能です。

しかし、EMCCDカメラは1台数百万円と非常に高価で、一般の企業や人々が手軽に使うことは難しい。そこで私たちは、スマートフォンに内蔵されているような一般的なシリコンカメラでも、夜間や暗い場所で鮮明な画像を得るための増倍機能をソフトウエアで実現する研究に取り組んでいます。一般的なカメラの能力を暗闇の中でも最大化できるソフトウエアを作ること、これが大きな目標です。

─どういった方法で研究をされているのでしょうか。

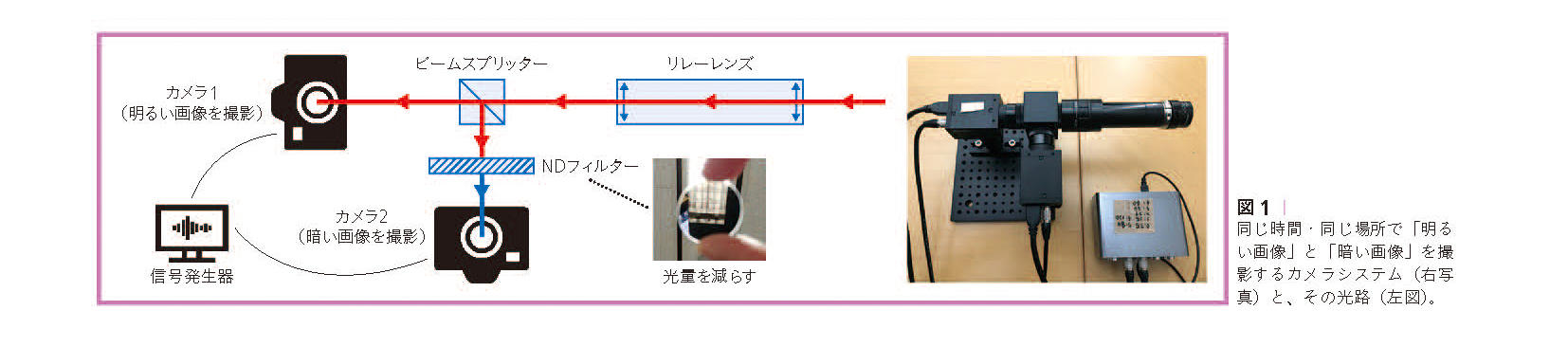

鄭 まず2台のカメラを用意し、同じ場所、同じタイミングで動画像(RGB[1]フォーマット)を撮影します。これは同じ時間・同じ場所で撮影した画像を「明るい画像」と「暗い画像」のペアで出力するためで、動画である点が重要です(図1)。それぞれのカメラのセンサーに光が届く前に、リレーレンズからビームスプリッターを介して一つのソースを分光して撮影するようにしています。なお、「暗い画像」を撮影するカメラにはND(Neutral Density)フィルターを装着し、カメラに入る光量を少なくしています。動画のフレームレート(コマ数)は30fps、撮影時間は5時間ほどで、1回の撮影で得られるデータ量は200ギガバイト程度になります。

そして、このペアのデータセットを使って深層学習を重ねていきます。深層学習を行う環境として、私たちは「U-Net」というセグメンテーション(分割)のためのニューラルネットワークを採用しており、暗い画像(フレーム)を入力し、明るい画像を出力できるようになるまでのモデルを生成しています。こうして得られたアルゴリズムを実装することで、一般的なシリコンカメラでも高解像のきれいな画像が得られるようになります。なお、深層学習のフレームワークとして、オープンソースの「PyTorch」を使っています。

─どういった分野での応用が期待されるのでしょうか。

鄭 大きく三つあります。一つめは、監視カメラです。夜間でも撮影できる監視カメラとしては近赤外線を使ったIRカメラなどがありますが、産業用であり一般向けではありません。暗い場所でも撮影可能な機能を実装することで、普通のカメラを監視カメラとして運用することが可能になります。現状ではズームイン/ズームアウトも可能になっているので、実用化への期待は高いですね。

二つめは、一般的なスマートフォンへの搭載です。現在、世界中の人々が毎日、ソーシャルネットワークに大量の画像をアップしており、暗い場所でもきれいな写真を撮りたいというニーズは大きくなるばかりです。このソフトウエア増倍機能は、そういったニーズを手軽にかつ安価に満たすことができるでしょう。もっともスマートフォンの場合は、撮影後すぐに画像が出力されないとユーザーの不満が募るので、リアルタイムに利用できることも実用化に向けての課題の一つです。

三つめは、ドローンや自動運転車などIoTへの応用です。夜間にドローンを飛ばしたり自動運転車を走らせるには明るいライトが必要になります。強いランプを搭載すると電力が足りなくなってしまうおそれがありますが、私たちの最新技術があれば消費電力を大幅に削減することが可能です。

課題としてはもう一つ、センサーの階調が現状では8ビット(256階調)なので、もう少し上げていきたいですね。また、CMY[2]フィルターを使って感度を上げていくことも検討しています。そうすればアルゴリズムの精度も上がり、より鮮明な画像を得られる可能性が高くなるので、「カメラの能力を最大化する」という目標にさらに近づけると思っています。

ファイバーケーブルや太陽光パネルの検査に応用

─同じような実験を静止画でもできるのでしょうか。

鄭 もちろんやっています。ここまで話してきたのは暗い場所で鮮明な画像を得るための研究ですが、シリコンカメラをSWIRイメージング(Short-wave infrared:短波近赤外光)を実現するInGaAsカメラ(インジウム・ガリウム・ヒ素センサーを搭載したカメラ)の性能に近づける研究もしており、それに静止画を使っています。実験の手法はほぼ同じですが、RGBをブロッキングするフィルターを使うのです。

─RGB画像はInGaAsカメラの性能に近づけるには不要ということでしょうか。

鄭 そうです。人間の目には見えないものを見えるようにするためには、逆にRGBの情報は除去したほうがいい。意図的にRGBを除去すると、可視光では見えないものが浮かび上がるようになります。

─この研究はどういった分野で使われるようになるのでしょうか。

鄭 いちばん期待されているのは海底に敷設されているファイバーケーブルの検査などでしょうか。一般的なシリコンカメラは400 ~ 1000nmの波長を捉えるように設計されていますが、ファイバーケーブルの損傷などをチェックするには1200nm前後の波長が使われています。実験ではこのフィルターを適用することでケーブルの状況を確認できたのですが、やはりまだ画像としては不十分です。もう 少しトレーニングを重ねて精度を上げていく必要があります。

ほかには、太陽光パネルのチェックなどにも応用できると思っています。太陽光パネルやファイバーケーブルのように、人間が近寄ってチェックすることができない部分をスキャンするのに必要なのはRGBではなく、InGaAsカメラ並みの性能を持ったセンサーなので、既存の高価なカメラにとって代わるくらいの性能をめざしたいですね。

「機械の目」と「人間の目」の役割はそれぞれ

─水中のビデオ撮影に適した3Dカメラの開発にも関わったことがあると伺っています。"機械の目"は人間の目を超えたと思われますか。

鄭 明確に"超えた"と思っています。最初にも申し上げましたが、人間の視力は非常に限定的です。情報のセンシングという面では明らかにコンピュータビジョンのほうが優れています。

しかし、だからといって人間が機械に劣るということではありません。人間の目はセンシングするだけでなく、脳にそれを伝え、視覚として捉えた情報を"理解する"という作業を一瞬で行います。これは機械がまったくかなわない分野です。機械が得意なことは機械に任せ、人間はそれぞれが得意な分野に集中したほうがいいのではないでしょうか。

─こうした研究を続けているモチベーションは?

東京工業大学で3次元復元を専攻し、企業に入ってからコンピュータビジョンとアルゴリズムの研究をするうちに、「見えないものを見えるようにするために、最高のカメラを使いたい、それには自分で開発するしかない」と思うようになりました。特殊で高価なカメラやフィルターではなく、誰もが使えるごく普通のカメラを使ってきれいな画像を得ること。課題は少なくないですが、データドリブンな時代になった現在だからこそ、実現に近づけていきたいですね。

(取材・文=五味明子 写真=古末拓也)