Interview

フェイクメディアを自動判定 「シンセティックビジョン」

シンセティックメディア国際研究センター

自然言語(文章)の生成AIに加え、画像や動画、音声の生成AIも急速な進歩を遂げている。本物と区別できない精巧な顔写真や声を作り出すことが容易になり、フェイクニュースや詐欺などに悪用される懸念も増している。こうしたディープフェイクに備えるシンセティックメディア国際研究センターの活動と、開発されたAI生成フェイク顔映像を自動判定する「シンセティックビジョン」について、センターを率いる越前 功 教授と山岸 順⼀ 教授に聞いた。

越前 功ECHIZEN, Isao

国立情報学研究所 情報社会相関研究系 教授

シンセティックメディア国際研究センター センター長

山岸 順一YAMAGISHI, Junichi

国立情報学研究所コンテンツ科学研究系 教授

シンセティックメディア国際研究センター 副センター長

聞き手山田 哲朗YAMADA,Tetsu ro

読売新聞 論説委員

1990 年、東京大学卒業、読売新聞入社。2006 年、マサチューセッツ工科大学(MIT)ナイト科学ジャーナリズム・フェロー。経済部、科学部、ワシントン支局を経て 2018 年に科学部長。2019 年から論説委員(科学技術担当)。

――シンセティックメディア国際研究センターの研究目標は何ですか。

越前 人間の顔や音声などを AIが学習し、本物と見まがうような合成画像や合成音声などの「シンセティックメディア」を生成することが 可 能になっています。バーチャルのアバターを作ってコミュニケーションしたり、動画や音楽を作成してエンターテインメントとして楽しんだり、いろいろな用途が生まれています。一方で負の側面として、詐欺や世論操作に悪用されたり、愉快犯が偽の映像や音声を拡散させたりする恐れも高まっており、大きな社会問題になりつつあります。

センターは、こうした不正な目的で生成されたフェイクメディアを検知し、メディアの信頼性を担保するための国際的な研究拠点です。

――発足経緯を教えてください。

越前 国の大型研究資金である戦略的創造研究推進事業(CREST)を獲得し2021年7月に発足しました。まず山岸教授が日仏の共同提案で、音声合成や声質変換などのテーマで研究を始め、続いて私がフェイクメディアへの対処手段というテーマで合流しました。お互い分野が隣接しているので、連携することで相乗効果が生まれ、多様な共同研究ができます。

山岸 CREST のプロジェクトが始まる前からも、実は一緒に共同で研究する機会が多々ありました。センターのメンバーである馬場口登・大阪大学特任教授を含め、ディープフェイク関連で先駆けとなるような研究もしていたので、元々こういう方向性で進んでいたということです。例えば、生成された音声ではなく、生身の人間の声かどうかを判定するライブネス検知の技術も、2014 年の時点で発表していました。

こうした分野は、今の言葉で言えば「生成 AI」や「情報セキュリティ」になりますが、当時はまだ「デジタルクローン」とか「メディアクローン」と呼ばれていました。コンセプトとしては同じで、AI 技術で作られた、あたかも本物のように見える画像や映像、音声、文章などについて、社会的問題や生体認証、セキュリティシステム上の問題点を洗い出し、事前に対処しようというものです。

――例えば自動翻訳はある段階から急速に改善され、一般人の語学力を上回るようになりました。画像や音声の場合はどうでしょう。

山岸 まず 2013年にディープラーニングの技術が音声の情報処理の分野にも入ってきて、音声認識の精度が劇的に良くなりました。しかも、人間の認識能力と同じレベルにあっという間に到達してしまったのです。音声合成もやはり 2013年以降、劇的な進化が起きて、2018年頃には、今あるアプリの原型となるような技術は既にできあがっていました。ただ、計算時間がかかるなど、商品として利用する際のコストの問題が残っていて、普及に時間がかかっていたということです。現在はコンピュータの能力が上がり、コストの問題も解決できたため、幅広く利用されるようになりました。音声の生成についても同様で、誰かにそっくりな声をコンピュータに模倣させることも本当に容易になり、誰でも利用できるようになってきました。画像生成でも有名な Stable Diffusion(ステーブルディフュージョン)などが登場しています。

越前 画像系では、顔を他の人の顔に置き換えるなどのディープフェイクの問題が出てきたのが2017年頃ですね。本物と見まがうようなものが出てきました。

真贋判定箇所を可視化

――センターが開発したフェイク顔映像の自動判定プログラム「シンセティックビジョン」が注目されています。

山岸 AI 技術の恩恵を広く受けられるようになったことはもちろんいいことなのですが、その一方で、モラルを欠く人が、顔を置き換えたフェイク動画などを手軽に作れる状況になってきたわけです。アプリを使って、一般の人でもディープフェイク映像を作れてしまいます。例えば、生成された架空の人物を「お客様の声」として登場させ商品宣伝に使ったり、他の人の顔を有名人の顔に置き換えて SNS 上にアップロードしたりすることが可能です。

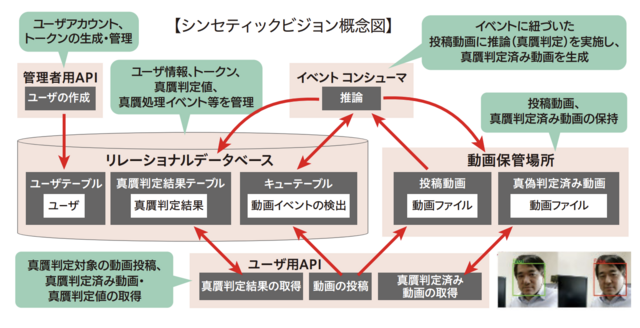

こうした問題に対処するために作ったのがシンセティックビジョンで、私たちが培ってきたリアルとフェイクを判別する技術を、実社会で使えるようにしたシステムです。様々な生成手法に対応しており、ぱっと見たところ人間には本物なのか偽物なのか分からないものでも、きちんと見抜くことができます。

――どのような仕組みで判定しているのですか。

山岸 基本的には、ニューラルネットワークが、リアル・フェイクの判定をするために参考になる箇所を探し出しています。結果だけ見ていると、中で何が起こっているかがわからないブラックボックス的な技術ではあるのですが、見て最終的に真贋を判定したのか、可視化できます。もちろん個々のフェイク画像や使用された生成アルゴリズムによって、着目点は変わります。そのため、一概に「ここがおかしい」とか「ここは変だ」とか、そういうふうには人間の目には見えないのですが、「ニューラルネットワークはここを参照した」という部分を示すわけです。

ある顔の画像を例(図1)にとると、AI は目のあたりとか、口のあたりに反応していますね。最終的に予測に役立ったのは、鼻のあたりでしょうか。別の顔の画像では、あごといった具合です。もっとも、これも、この画像の、この加工の方法に限った話であり、いつもそう言えるわけではありません。いずれにせよ、ニューラルネットワークが見ているところが必ずしも人間にとっても役に立つポイントではないので、いつも説明には困ります。これは、残念ながらディープラーニングすべてに共通する性質です。

フェイク検知こそミッション

――シンセティックビジョンは、ずいぶん早く社会実装が実現しましたね。

越前 フェイクメディアについて心配している企業、またはそこにビジネスチャンスを感じている企業は結構多いのですが、企業がすぐ開発できるものではありません。まず、どのディープラーニング技術にも共通することですが、学習のため大量の映像データが必要で、大量のフェイクデータも必要になります。次に、巨大なニューラルネットワークが必要になります。最後に、その巨大ニューラルネットワークを効率よく学習させることができる GPU(画像処理半導体)サーバが必要で、かなり参入障壁が高いのです。それが、まだ日本では私たち以外にこういう真贋判定サービスを提供している企業が極めて少ない理由でもあると思います。

私たちは、企業がビジネス用途ですぐ使えるよう、必要になるだろうすべてのモジュールをデザインしました。ユーザ登録用のモジュールとか、動画を受け付けるモジュール、真贋判定した結果を可視化するモジュールなど、すべてのプロセスに必要な構成要素を作ったわけです。ここまでしないと、私たちがコアとなる技術を開発しても、結局、それを使ってはもらえません。

――研究者がサービス提供の段階にまで関わるのは珍しいかと。

越前 背景にあるのは、やはり生成 AI の分野の動きが速いことです。研究者が核となる推論の部分にだけ注力し、「あとの周辺の部分は全部作ってください」と人に渡してもうまく進みません。私たちは 2018 年に世界で最初に顔映像を対象とした真贋判定のモデルを発表しました。そうした先見性もあり、早くから必要性を感じていたわけです。「自分たちで、一気通貫で作った方が早いだろう」という判断でこれまで動いてきました。

――企業からの引き合いは多いですか。

越前 すでに、デジタル広告大手の株式会社サイバーエージェント様で採用され、実際に使用されているほか、問い合わせもかなり寄せられています。2021年9月に発表して以来、照会が一番多いのは、よくある著名人のディープフェイク検知ではなく、eKYCと呼ばれるオンラインの本人確認におけるディープフェイク検知でした。オンライン認証で不正な申請を検知したいというニーズが多いのでしょう。

山岸 こうしたサービスは、まだいろいろな企業が提供するという状況になく、私たちは現在、パートナー企業を探しており、そのパートナー企業を通じて多くの人に使ってもらいたいと考えています。

――NII を中心にオールジャパンで開発する意義は何ですか。

越前 ChatGPTが注目を集め、今、「国産の大規模言語モデル(LLM)も必要だ」という声が高まっています。ポイントは国産というところで、要するに海外のものがデファクトスタンダードになってしまうと、その技術は海外にコントロールされてしまうわけです。相手の一方的な都合で「サービスの提供をやめます」「機能を絞ります」ということが決まってしまうわけです。

同様に、フェイク検知について独自の国産モデルを開発し、偽情報対策を強化することは、国全体にとって非常にメリットが大きいと考えます。まだ細々とではありますが、これが我々のミッションと思って研究開発を継続していきたいと思います。

聞き手からのひとこと

生成AIは、悪用されれば民主主義や選挙制度を揺るがす。ディープフェイクの脅威から社会を守る技術基盤は、自前で開発し維持することが必須だ。安全保障や民主制の堅持など戦略的な観点から、国が継続して研究開発を推進してもらいたい。 (読売新聞 論説委員 山田哲朗)

関連リンク

- シンセティックメディア国際研究センター

- ニュースリリース:国立情報学研究所によるフェイク顔映像の真贋自動判定プログラム「SYNTHETIQ VISION」のライセンス事業者を募集

- 越前 功 - 情報社会相関研究系 - 研究者紹介

- 山岸 順一 - コンテンツ科学研究系 - 研究者紹介