Interview

動き始めたLLM勉強会

計算基盤と言語モデル構築基盤を整備し、 研究環境の土壌を作ることが重要

国立情報学研究所(NII)は国内大学や企業の自然言語処理研究者が集うLLM勉強会を発足させた。「競争より共創」の旗印を掲げ、「オープンソースで日本語に強い大規模言語モデル」を構築、関連した研究開発を進めるとともに研究者間のネットワーク作りと「AIネイティブ時代」の新たな人材育成を狙う。勉強会の主要メンバーであるNIIの相澤 彰子教授(副所長)、金澤 輝一准教授、菅原 朔助教の3人に勉強会設立の背景や狙い、波及効果などを語ってもらった。

相澤 彰子AIZAWA, Akiko

国立情報学研究所 副所長

コンテンツ科学研究系 教授

金澤 輝一KANAZAWA, Teruhito

国立情報学研究所

コンテンツ科学研究系 准教授

菅原 朔SUGAWARA, Saku

国立情報学研究所

コンテンツ科学研究系 助教

聞き手滝 順一TAKI, Junichi

日本経済新聞

編集委員

早稲田大学政治経済学部卒業後、日本経済新聞社に入社。1980 年代半ばから科学技術の研究開発現場と科学技術政策の立案プロセスを取材し、現在は科学技術や環境分野を担当している。著書に『エコうまに乗れ!』。

―― まずはじめに、LLM 勉強会の狙いなどについてうかがいます。

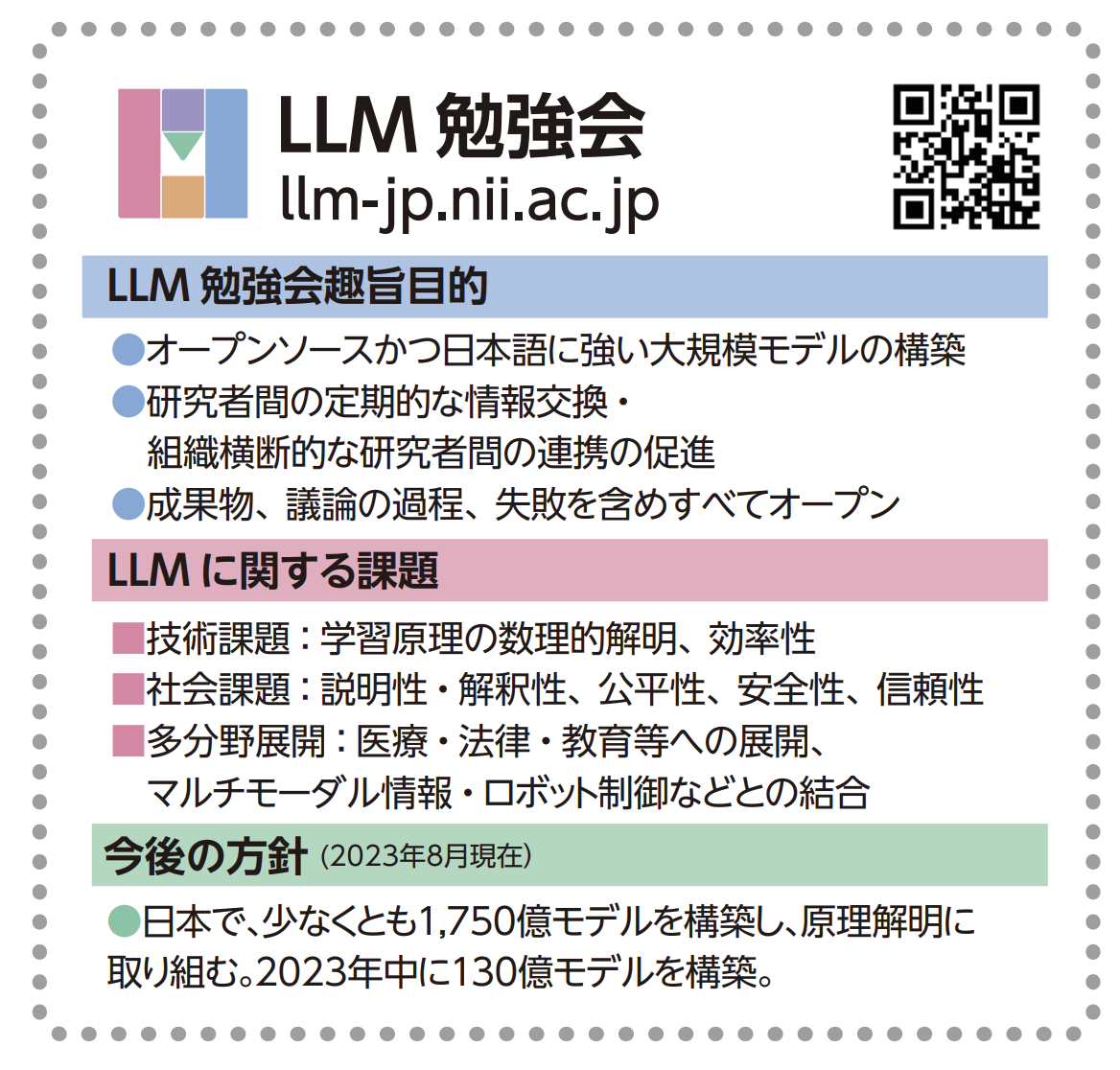

菅原 NII の黒橋所長が呼びかけ、日本国内の自然言語処理研究者が勉強会に集まっています。日本語に強い大規模言語モデル(LLM)を作り、その原理解明や活用の研究を促進することが目的です。5月に第1回を開き、7月に第 3回を開きました。2023年8月の時点で 300人を超える方が参加登録しています。

―― 勉強会ではワーキンググループを設けているそうですね。

菅原 4つあります。大規模言語モデルの学習・訓練に必要なデータをそろえるグループ。モデルを構築して訓練するグループ。モデルを特別な目的にチューニングしたり評価したりするグループ。そしてモデルを作るのに必要な大規模な計算機インフラを整えるグループがあります。

相澤 国立大学の情報基盤センターや NII などの複数の学術組織が共同で運用している mdxという大規模な計算機基盤(データ活用社会創成プラットフォーム)があります。その基盤を使い大規模言語モデルを構築するプロジェクトがスタートしました。大規模言語モデルと言われているものの中では規模は小さいですが、(パラメータ数で数えて)130億のモデルを2023年中にはリリースする予定です。勉強会では1,750億規模のモデルを目標に置いています。

モデルを作るだけではなく、いろいろなドメイン(分野)に使えるようモデルをどう適応させるか、どういう活用ができるか、自然言語処理の研究に使うのか、社会課題解決に役立てるのか、(モデルを作った)後のフェーズではそうしたさまざまな活動がスタートすると思います。

大規模言語モデルはファウンデーションモデルとも呼ばれるように、あらゆる場面で使える点が大きな特徴です。画像処理やロボット、医学・バイオ、材料など計算機を使う科学のコミュニティや、さらに将来はありとあらゆる研究コミュニティが関わって、大きな活動になっていくのだと思います。

例えば社会科学です。言語を介して社会というものを解析していくのも重要な研究分野です。人間の言語とは何かというサイエンティフィックな問いに答えていくのも勉強会のミッションになると思います。日本語に強いモデルであるという観点から言えば、言語モデルは社会の規範やルール、社会におけるさまざまな人間の活動を捉えている側面があり、私たちの社会を観察していく観測・分析ツールにもなることも考えられます。

LLMで情報検索も高度化

金澤 私は、NIIが提供する学術情報検索基盤のCiNii Research(サイニィリサーチ)の開発チームで、自分の研究成果を応用した改良を進めています。LLM勉強会には CiNii Researchへの大規模言語モデルの適用を想定した研究開発と実用化を念頭に置いて参加しています。研究分野ごとはもちろん、ドメインに特化しない形でドメイン横断的にいかに学術情報コンテンツに容易にアクセスできるようにするか。そこに大規模言語モデルを役立てていきたい。

かつては情報検索といえば、情報に緻密にメタデータを付けておき、利用者は検索式を適切に書いて検索すれば絞り込みがきちんとできるというシステムで、使いこなすのはなかなか容易ではありませんでした。CiNii Research ではキーワードを入力すれば、候補が出てきて、さらに絞り込むにはどうするのかという選択肢も与えてくれます。複雑なクエリ(処理要求)を人間が考えなくても絞り込みをうまくやれるようになりました。ただシンプルなユーザインターフェースで対応しようとすると、逆に要求を適切に表現できないこともあります。

大規模言語モデルに複雑な検索式を書かせれば、自然言語の入力文で適切な指示ができると考えています。こういうことがしたいとの要望をプログラムコードに落とすのは大変ですが、大規模言語モデルを利用して短時間で質の高いコードを書けるようになりました。プログラムの世界では、プログラミングの知識を持たなくても動作を指示できる「ノーコード・ローコード」が提唱されていて、大規模言語モデルで複雑な動作にも対応することが期待されています。検索でも「ノーサーチ・ローサーチ」みたいに、こういうことを知りたいと尋ねるだけでほしい情報にアクセスできるようにしたいと考えています。

また研究活動の促進・支援に向けた研究力分析・強化の技術開発も個人の研究テーマの一つです。そこで異分野融合研究のための研究者のマッチングシステムを考えていますが、異分野の研究者が研究テーマを相互にわかるように説明するのは難しく時間がかかります。大規模言語モデルの応用でより短時間で互いをわかり合えるシステムができるのではないかと研究しています。相澤先生が言及されたように、情報学、医学、社会科学などあらゆる分野の研究者の共同研究を促すようにできればと思います。

後進のための研究環境の土壌作り

菅原 若手研究者の立場からコメントします。大規模言語モデルは米国の大企業が主導しており、研究のためにオープンに提供され利用可能なモデルを再現するだけでとてもお金がかかります。オープンソースで無償で使えるもので最も規模が大きなものを動かそうとするだけで 1,000万円くらいのサーバ が手元にないとできません。若い研究者や学生にとって大きな障壁です。

また日本の個々の研究室が必ずしもたくさんお金を持っているわけではありません。みんなが集まって計算機基盤もデータも共有、コードもプログラムも共有しながら作るのであれば、学生やポスドクも含めて関わることができます。それが大きなメリットの一つです。

私個人としてはモデルの評価に関心があります。最近のモデルでもちゃんと文章が読めているのか怪しいところがあります。答えの根拠まで説明させようとするとちゃんと説明できないかもしれないという課題があるとみています。

相澤 大規模言語モデルをアカデミアで開発するということと、日本語に焦点を当てて作ることの2つの側面があると思います。ChatGPTを契機に言語モデルの大規模化が一気に進みました。急速な変化の中で、自然言語処理、あるいは人工知能と言ってもいいかもしれませんが、急にビッグサイエンスになったと思います。予算の桁は違いますが、分野の研究者の力を結集しなければ進んでいけないという点で、素粒子物理学で大型加速器が必要なのと同様のビッグサイエンスの土俵の上に、私たちがいきなり乗った感じです。

黒橋所長が音頭を取って登壇もされた2023年3月の自然言語処理学会年次大会の緊急パネルを契機として、力を合わせようという機運が高まったと思います。シニアの研究者は5年後のことを考え、後輩の研究者のためにやらなくてはいけない、と、気持ちが一つになったという思いがありました。LLM 勉強会はオープンなモデルを作り大勢に使ってもらおうという狙いがある一方で、シニア研究者としては、後進のために大きなサイエンスの場を作るという意識があります。

一方、私はデータ中心のサイエンスの時代において、受け身のままでは日本のアイデンティティを守ることが難しいという問題提起を数年前からしてきました。日本にある情報にしっかり投資していくことが重要だと思える一方で、そういうことは研究業績にはなりません。論文を書きインパクトファクターの高いジャーナルに投稿するのを競う風潮の下で、日本の情報に焦点を当てるモチベーションが見当たりません。日本のアイデンティティとしての言語や情報を蓄積する活動に、ここでしっかり取り組むことが重要だとする点でも多くの研究者の思いが一致したと思います。

―― 大規模言語モデルの科学研究へのインパクトをどうご覧になりますか。

金澤学術情報へのアクセスが容易になる、コストが下がるといったことは、研究ドメインによらず大きな意味があると考えています。どのような分野でどんな役立て方があるのか、具体例を示すことはできませんが、LLM勉強会で作るモデルがさまざまな領域で使用され、その評価がいずれ出てくるはずです。情報検索やアクセス技術の研究者として、心待ちにしています。

菅原 AI 分野では近年、力のある研究者が大勢集まってチームで研究し論文を書くのが当たり前です。研究者の横のつながりを強めるのは世界にインパクトのある成果を出す上で大事なことです。アカデミアが牽引してチームを形成するのが望ましく、LLM勉強会はそのハブになる役割として意味が大きいと思います。

相澤 大規模言語モデルが科学にもたらす影響は非常に大きいと考えます。本当にクリティカルな影響があり、あらゆるところで研究を加速しうると思います。バイオテクノロジーの研究者にどんな使い方をするかを尋ねたところ、遺伝情報のデータベース検索で、私のような自然言語処理の研究者が思いもよらない高度な使い方を想定されていました。

LLM研究は、脳と言語の研究につながるのか

―― 大規模言語モデルがどうやって流暢な文章を生成するのか、そのメカニズムの研究は、人間の言語の研究や、脳がどう言語を扱っているのかという問いへの答えにつながるのでしょうか。

菅原 言語モデルを観察してわかることが必ず人間の脳に当てはまるかというと難しいことが多いと思います。ただこういう条件の下でつくったら人間らしく振る舞ったとか、こうした条件では振る舞わなかったということはわかります。ですから人間と同等に振る舞う条件を絞り込んでいったり、こういう情報を学習させたらこういうことがわかったりと、作り方の工夫をしていくうちに人間の脳にも類推的に言えることがもしかしたらあるかもしれません。

まだ誰も明確な答えが出せるものではありませんが、言語学や認知科学、神経科学などの研究者とコミュニケーションがより活発になることがひとまず一番大事かなと思っています。

相澤 私はつながると思っています。仕組みはまったく違うはずですが、脳研究の分野で脳波のデコーディングに言語モデルを利用した結果、解釈がうまくいったりするという話を耳にします。モデルは言語を理解する脳の働きの何らかの特徴をうまく捉えているのだと推測します。これも勉強会の今後のテーマになりえます。

聞き手からのひとこと

新聞記事は多くの記者の仕事の蓄積であり新聞社の資産である。日本新聞協会は報道コンテンツが無断・無秩序に利用されることに懸念を表明している。一方で新聞記事は公益性を有し適切な権利保護の下で利用を促す道も模索されるのが望ましいと個人的には考える。 (日本経済新聞 編集委員 滝 順一)